1. Spontaneous EEG Potentials

1) 수면

불면증을 진단하고 수면의 단계(non-REM1~4, REM [R&K rules])에 대해 분석할 때 사용된다. 이런 용도의 분석에서는 50Hz Notch, 30s windows를 주로 사용한다. Vilamala et al, 2017에서는 Fpz-Cz, Pz-Oz channel에서 얻은 EEG 신호들을 CNN을 통해서 5-class classification에서 86% 정확도를 확인할 수 있었다. Tan et al., 2015에서는 DBN-RBM에 PSD feature를 넣어서 92.78%까지도 향상시키는걸 볼 수 있었다.

2) Motor-Imagery (MI)

사용자의 운동 의도를 탐지하는 MI EEG는 주로 DBN (Deep Belief Network)를 활용한다 (Kumar et al., 2016, Lu et al., 2017). 이 분야는 수면과는 다르게 아직 70%대로 성능이 좋지는 않은데 그래서 다양한 시도들이 이루어지고 있는듯하다. Event-related desynchronization/synchronization (ERD/ERS)를 사용하기도 하는데, 이는 뇌가 특정 상태일 때 EEG signal power의 magnitude, frequency distribution이 달라지는 것에서 감소하면 ERD, 증가하면 ERS를 나타낸다. 이 특징으로 EEG fluctuation을 탐지할 수 있는데, ERD/ERS는 sensory, cognitive, motore procedures task에서 주로 관찰된다. 하지만 개인차가 심하기 때문에 다른 brain research에서는 잘 쓰이지 않는다.

3) 감정

감정은 valence, arousal, dominance 3가지로 상태를 평가하는데, 이 3가지 조합으로 fear, sadness, anger 등의 감정을 만들어낸다. MLP가 주로 사용됬었지만 최근에는 CNN, RNN이 더 많이 사용되고 있다. 추가로 Eye movement+EEG 데이터를 bimodal deep autoencoder (BDAE) 과 SVM으로 분석을 했을 때 성별에 따른 감정의 차이가 있다는 것을 찾은 연구도 있었다 (Liu et al., 2016). 그래서 이 차이를 줄이고자 Subsapce alignment autoencoder를 만드는 연구들도 진행되고 있다 (Chai et al., 2016).

4) 정신 질환

https://github.com/AITRICS/EEG_real_time_seizure_detection

5) Data Augmentation

최근 연구들에 따르면 GAN 같은 모델이 EEG data augmentation으로 활용될 수 있다고 한다 (Abdelfattah et al., 2018). Palazzo et al., 2017은 EEG 신호 feature를 GAN을 통해 image로 변환하기도 하고, Abdelfattah는 seizure EEG data를 GAN을 통해 증강함으로 정확도를 48%에서 82%까지 끌어올릴 수 있었다. (이전 post 참고)

6) Etc: EEGNet (https://arxiv.org/abs/1611.08024, https://github.com/aliasvishnu/EEGNet)

2. Evoked Potentials

1) ERP (P300)

Visual, Audio 두가지 sensory에 대한 P300 (Oddball, P3 Speller) 신호를 classification하는데 주로 사용된다. 2~35Hz bandpass filter를 적용한 데이터를 갖고 학습을 하는데, Liu et al., 2017에서는 DBN-RBM + SVM으로 97.3%까지 결과를 얻을 수 있었다. 해당 Dataset으로는 유명한 BCI Competition II가 있다 (https://www.bbci.de/competition/ii/). AEP의 경우 0.1~8Hz freq band 범위에서 sample rate를 256에서 25Hz까지 downsample하여 분석하는 것이 더 좋은 결과를 보인다고 한다. Audio processing에서 주로 쓰이는 SincNet (low and high cutoff frequencies에 더 attention 둠)를 통해 feature extraction을 하는 경우도 있다.

VEP diagram 중에 Rapid Serial Visual Presentation (RSVP)가 가장 인기가 많은데, CNN, MLP모델로도 좋은 성능이 report 되고 있다. RSVP는 연달아서 나오는 이미지/텍스트 중에 연관성이 없는것이 나오면 report하는 테스트입니다. 0.1~50Hz까지 넓게 사용되고 LSTM 같은 모델에서도 좋은 성능을 보인다고 한다.

2) SSEP

대부분 Visual을 중심으로 하는 SSVEP를 기반으로 연구가 진행되는데, SSVEP는 특정 주파수로 깜빡인는 자극을 볼때 나오는 parietal, occipital 영역 뇌파를 기반으로 한다. CNN+RNN 모델로 93.5% 정확도를 얻은 논문 (Attia et al.,2018)부터 compact CNN model로 cross-subject 정확도 향상 시도 (Waytowich et al., 2018), DFT 후 CNN/LSTM에 넣는 등 다양한 시도가 되고 있다. 그런데 online / offline, subject-in/dependent 한 요소들도 고려되어야하므로 오히려 간단한 CNN 모델이 더 좋은 성능을 보이는 경우가 많이 있다.

3. Applications

위의 논문들에 기반하면 간단한 CNN 모델만으로도 70%대 정확도가 나오는 걸 확인할 수 있었습니다. 이는 CNN이 충분히 EEG의 latent discriminative feature와 spatial dependencies를 뽑아낼 수 있기 때문이다. 또한 CNN 모델들이 public한 repo가 많기 때문에 이를 EEG에 적용해보는 시도들이 필요하다고 한다. 그리고 1D (signal)인 EEG를 여러 방법으로 2D로도 변환 가능하다. 예를 들어 각 time point를 2D image로 변환하거나, segment를 2D matrix로 만드는 방법 (32 channel x 100 time point) 을 선택할 수 있다.

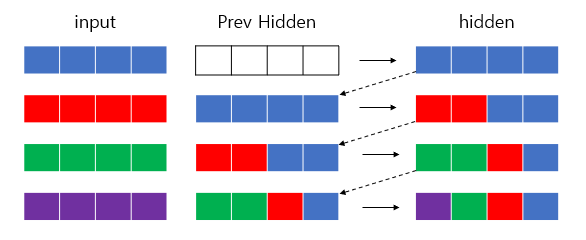

Representative model (DBN)의 경우 주로 DBN-RBM이 사용되는 걸 볼 수 있었는데, 이는 근처 layer의 변수 간 관계를 보여주는 generative param를 효율적으로 학습하고, 각 hidden layer의 latent var를 직관적으로 계산한다는 점이다 (Deng, 2012). 한동안 DBN이 잘 쓰이지 않다가 최근들어 CNN과 같이 하이브리드 형태로 사용되고 있다.

이런 model을 기반으로 BCI는 헬스케어, Smart Environment (IoT, Robot control 등), 통신, 보안, 감정, 운전 피로 등 다양한 분야에서 활용되고 있다.

'Cognitive Neuroscience > BCI' 카테고리의 다른 글

| Machine Learning on EEG Data (1) | 2022.03.15 |

|---|---|

| 2. Brain Signal Acquisition (0) | 2021.12.25 |

| 1. Introduction (0) | 2021.12.04 |